티스토리 뷰

1. 기울기

손실 함수에 대한 모든 매개 변수의 편미분을 담은 벡터를 기울기(gradient)라고 한다.

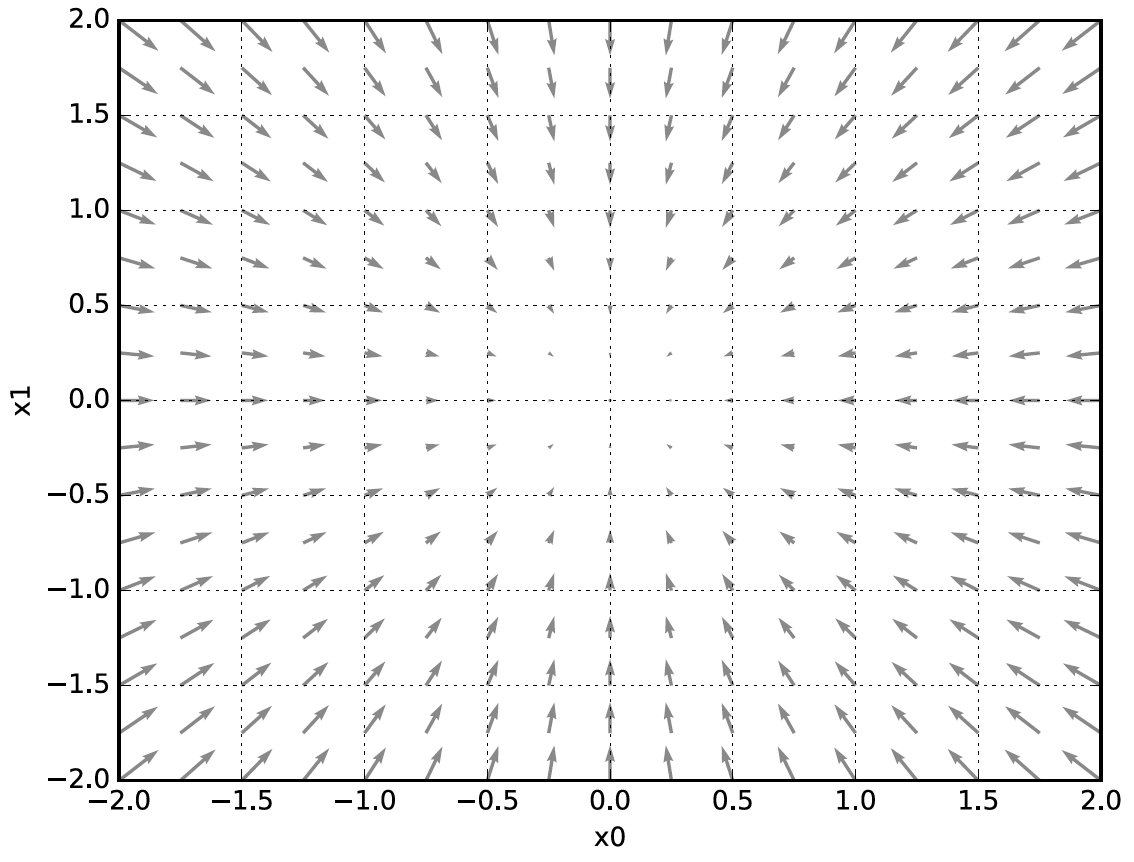

기울기는 무엇을 의미할까? 위 그림은 기울기에 음수를 붙인 벡터를 시각화한 것이다. 기울기는 함수의 가장 낮은 장소(최솟값)을 가리킨다. 또한 가장 낮은 곳에서 멀어질수록 화살표의 크기가 커진다. 사실 화살표가 반드시 함수의 가장 낮은 장소를 가리킨다고 할 수 없다. 더 정확히 말하자면, 기울기가 가리키는 쪽은 각 장소에서 함수의 출력값을 가장 크게 줄이는 방향이다.

2. 경사 하강법

경사법은 현 위치에서 기울어진 방향으로 일정 거리만큼 이동하는 방법이다. 그 다음 이동을 마친 곳에서 마찬가지로 기울기를 구하고 또 일정 거리만큼 이동하기를 반복한다. 이렇게 하여 함수의 값을 점차 줄이는 것이 경사법이다. 신경망 학습에는 경사법을 이용한다.

경사 하강법을 수식으로 나타내면 위와 같다. $\eta$는 갱신의 양을 나타낸다. 이를 학습률(learning rate)라고 한다. 학습률은 하이퍼파라미터이다.

'밑바닥부터 시작하는 딥러닝1' 카테고리의 다른 글

| 매개변수 갱신 방법 (2) | 2023.12.05 |

|---|---|

| 오차역전파법 (0) | 2023.12.03 |

| 학습 알고리즘 (0) | 2023.11.30 |

| 신경망 학습 (0) | 2023.11.26 |

| 신경망 (0) | 2023.11.25 |